Esta tecnología, cada vez más presente en la vida de las personas y los planes de las compañías tecnológicas, tiene un gran consumo de energía que surge de los centros de datos que la posibilitan, y que despiertan la alarma de distintos investigadores y organizaciones globales.

La inteligencia artificial está en las pantallas de todos y parece destinada a quedarse entre nosotros: millones de personas usan todos los días asistentes motorizados por esta herramienta, las aplicaciones más populares la integran a sus plataformas y tiene un rol protagónico en las estrategias de las grandes compañías tecnológicas para el futuro. Pero este brillo podría ser fuego en lugar de oro, ya que cada vez más personalidades y organizaciones ―desde Elon Musk hasta el foro de Davos― advierten que esta tecnología genera un enorme consumo de recursos, que podría dejar a la humanidad cerca del colapso energético.

Para entender la causa de este problema, hay que llegar hay que saber que esta herramienta, tan etérea en la apariencia, tiene un pie a tierra tan palpable como una piedra o una flor: los centros de datos (data centers) en los que funcionan sus servidores, en los cuales centenas de chips hacen miles de millones de cálculos automáticos para “entrenar” la inteligencia artificial y luego, una vez que es lanzada al público, generar sus respuestas.

La manera más simple en la que el Dr. Diego Slezak, director del Laboratorio de Inteligencia Artificial Aplicada de la Universidad de Buenos Aires (UBA), puede describir este hardware a LA NACION, es como “cajas de pizza donde adentro tenés los chips de placas de video, del tamaño de ravioles, que pueden ser 4, 8, 16 o incluso 64, según avanza la tecnología”. Esta imagen se multiplica en los centros de datos: “Literalmente hay cientos de racks, de más o menos 2 metros, con 20 cajas de pizza apiladas″.

Interior del centro de datos de Google en Council Bluffs, Iowa; este tipo de construcciones demandan gran cantidad de energía y agua para refrigerarse, y aquellos destinados a la inteligencia artificial demandan aún más de estos recursosGoogle

Se trata de lugares frescos, con “ventiladores en el rack, ventiladores en los pasillos, en el aire acondicionado, en cada una de las máquinas y las placas de video” que buscan contrapesar los 80 grados a los que puede llegar a calentarse cada uno de estos chips en su trabajo computacional, lo cual además de un gran consumo de electricidad también genera “un ruido ensordecedor, como de una turbina”, que hace que sólo se pueda ingresar a los data centers con tapones de oído.

Por qué la IA podría acercarnos al colapso energético

Los centros de datos que posibilitan la IA plantean un problema energético al momento en que, como señala Slezak, “cada placa de video consume 100 watts, y si tenés miles funcionando todo el tiempo tenés al menos 100.000 watts de uso constante en un centro de datos”. Además, el doctor en Computación señala que su calor también se refrigera con agua, a través de circuitos cerrados conectados a cada “caja de pizza”.

Como señala el World Economic Forum, también llamado Foro de Davos, “los sistemas generativos de IA ya necesitan hasta 33 veces más energía para completar una tarea que un sistema de tarea-específica”, como puede ser una búsqueda en Google. Actualmente, el desarrollo de herramientas de este tipo representa desde un 2 a 3% de la energía mundial, aunque la misma fuente señala que “esto probablemente cambie a medida que más compañías, gobiernos y organizaciones usan inteligencia artificial para aumentar su eficiencia y productividad”.

Estas palabras dan con un punto clave en el que coinciden distintos expertos: el cuello de botella actual de esta tecnología, generado por la falta de infraestructura y fabricantes de chips a nivel global, ataja de momento un problema que posiblemente se espiralice en el futuro cercano, cuando estos obstáculos de producción se superen.

Así lo señaló el magnate tecnológico Elon Musk, quien en febrero de este año habló sobre la cercanía de un futuro donde el colapso energético pueda ser una realidad: “La próxima limitación [de la inteligencia artificial] va a ser la electricidad. No van a poder encontrar suficiente electricidad para todos los chips, creo que el año que viene ya se va a ver que no habrá suficiente energía para todos”, advirtió en una aparición virtual en la Bosch Connected Conference.

Las noticias parecen demostrar que las inversiones en centros de datos para motorizar inteligencia artificial generativa no disminuyen, sino al contrario: Google planea invertir más de 1000 millones de euros para expandir su infraestructura de IA en Finlandia, y 2000 millones con el mismo fin en Malasia. Por su parte, Amazon anunció planes para invertir más de 100.000 millones de dólares en este rubro durante los próximos 15 años, mientras que Microsoft ya oficializó este año la mayor inversión en data centers de la historia de Francia, por más de 4000 millones de euros.

En paralelo, todas estas compañías tecnológicas más que duplicaron su consumo energético entre 2017 y 2021, según un paper publicado en mayo de este año por Alexandra Sasha Luccioni y Yacine Jernite, de la empresa de IA estadounidense Hugging Face, en colaboración con Emma Strubbel del Instituto Allen para la Inteligencia Artificial. De manera consiguiente, también duplicaron sus emisiones de carbono, resultantes de la generación de esta energía a través de combustibles fósiles.

Cuál es el tipo de inteligencia artificial que utiliza más recursos

El término “inteligencia artificial” abarca distintas ramas, que a su vez varían en su consumo energético según el tamaño de sus modelos y su estructura. Para la alarma de muchos, la más popular de estas variantes, la inteligencia artificial generativa, aquella que tarda segundos en producir textos o imágenes a pedido, es también la que usa más recursos.

La generación de una imagen en un modelo de inteligencia artificial puede consumir tanto como media carga de un smartphone, y 1000 imágenes el equivalente a la carga de 522 teléfonos, según el paper de Luccioni, Jernite y Strubbel. Teniendo en cuenta que, al momento de su lanzamiento, ChatGPT —solo el primero de los cada vez más numerosos modelos de inteligencia artificial generativa— tenía 10 millones de usuarios por día, estos números se multiplican exponencialmente. En contraste, el uso de la inteligencia artificial para la clasificación de textos e imágenes consume hasta 10 veces menos energía, según la misma fuente.

La inteligencia artificial generativa, responsable de imágenes como esta de una campaña de Toys «R» Us, es la que más energía necesita, ya que puede llegar a requerir el equivalente a media carga de un smartphone para hacer una sola imagen.

Para el científico de datos neerlandés Alex de Vries, que lleva más de 10 años investigando los efectos colaterales de las tecnologías digitales a través de su plataforma Digiconomist, este paisaje es especialmente frustrante: “A diferencia de otros usos de la IA que pueden ser útiles sin consumir tanta energía, por el momento la inteligencia artificial generativa no está contribuyendo nada y costando mucho, si mirás a las grandes firmas tecnológicas apenas pueden explicar cuáles son sus beneficios, qué obtenemos de estos enormes modelos de lenguaje más allá de algunos titulares graciosos”.

En su opinión, lo que guía las inversiones mil millonarias en este sector es la esperanza corporativa: “Creo que estas compañías todavía tienen mucha fe en lo que esta tecnología puede traerles, pero hasta el momento no se materializa, es solo un pozo sin fondo en el cual los inversores tiran su dinero sin ningún retorno”, elabora antes de lanzar una advertencia, anclada en la historia, para los tiempos por venir.

Una paradoja del pasado para el futuro

De Vries, doctorando en la Universidad Libre de Ámsterdam, lleva varios años aportando a la discusión del impacto ambiental de tecnologías como la minería de criptomonedas, y el año pasado llegó a los titulares de medios de todo el mundo por un estudio —“optimista” según sus propias palabras— que sostuvo que el crecimiento de la infraestructura de IA podría llevar a que este sector consuma la electricidad anual de naciones como los Países Bajos, la Argentina o Suecia para 2027. Con este pronóstico, no teme en decir a LA NACION que “la dinámica actual de la inteligencia artificial es incompatible con la ecología”.

El científico de datos ahonda en esta perspectiva que ensombrece su visión particular del futuro: “La IA tiene un problema único dentro del mundo digital, que es que para muchos de estos modelos, especialmente los generativos, más es mejor, cuántos más parámetros, más datos tengas, mejor funcionan los modelos. Obviamente, poner más requiere más poder computacional y más electricidad para que estás máquinas funcionen, y por eso creo que esta dinámica es fundamentalmente incompatible con la sostenibilidad ambiental”.

Aunque tanto el Foro de Davos como las empresas tecnológicas sostienen que la evolución de la infraestructura y el hardware de la inteligencia artificial podría reducir su consumo energético o hacerla dependiente de energías limpias, para de Vries esto es “voluntarismo”.

Para justificar su pesimismo, el científico retoma la paradoja elaborada por el economista y filósofo británico William Stanley Jevons (1835-1882) en la segunda mitad del siglo XIX: “Cuando hacés las tecnologías más eficientes, también las hacés más baratas, por lo que el consumo de las mismas sube y la demanda total con la que terminás excede aquella con la cual empezaste”. Esta lógica, sostiene, se vio en la época de Jevons, con el perfeccionamiento de los combustibles fósiles, “a lo largo de 160 años de revolución industrial”, y “bien podría ser el caso de la inteligencia artificial”.

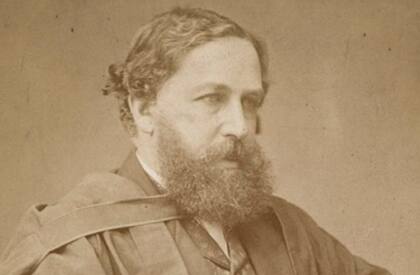

William Jevons (1835-1886) planteó que hacer una tecnología más eficiente aumenta su consumo y anula los beneficios ambientales de dicho avance, paradoja que muchos aplican al desarrollo de la IA.

William Jevons (1835-1886) planteó que hacer una tecnología más eficiente aumenta su consumo y anula los beneficios ambientales de dicho avance, paradoja que muchos aplican al desarrollo de la IA.

De Vries ve similitudes entre esta y otras novedades digitales que vio en su experiencia: “Llevo varios años trabajando con tecnologías emergentes y cada vez es lo mismo, están rodeadas de tanto hype y FOMO (miedo de perdérselo, por sus siglas en inglés), que todo el mundo empieza a colocarlas en problemas completamente irrelevantes. Piensan ‘ah, tengo un problema, la IA va a resolverlo’, pero es como usar un bazooka para matar una mosca”, ilustra.

Por eso, recuerda que “lo mejor para el planeta es usar menos, no más”, y pide a las personas que “den un paso atrás” antes de usar este tipo de herramientas: “Si empezás a pensar en el desafío que te planteás y cuál es la mejor manera de resolverlo con todas las otras tecnologías disponibles, 9 de 10 veces no vas a necesitar la IA”.

Además, enfatiza en que las compañías tecnológicas deben comenzar a dar la información precisa de cuánta energía gastan en entrenar y desplegar modelos de inteligencia artificial, algo que empresas como Google hacían en el pasado y luego dejaron de hacer: “Era la única compañía que hacía esa distinción, lo que mostraba que en el período 2019-2020, el 15% de su consumo energético surgía del entrenamiento de modelos de IA”. En su opinión, esta opacidad “no es puramente por el aspecto ambiental”: “El costo de desplegar la IA se está volviendo muy alto, y creo que para ellos es demasiado revelador desde el lado comercial”.

Por esta actual falta de transparencia, sumado a las crecientes inversiones en el sector de la inteligencia artificial generativa, de Vries sintetiza: “Definitivamente no veo que este problema pare en el corto plazo, pero con suerte la situación cambie en el mediano y largo plazo”. Cuando se le pregunta si ese deseo no es voluntarismo, contesta con una sonrisa: “Si las grandes compañías tecnológicas pueden ser voluntaristas, nosotros también podemos serlo”.

(Por Franco Roth para La Nación // Imagen principal: El alto consumo energético de la inteligencia artificial es un tema que preocupa cada vez más a organismos y personalidades del sector)

ADNbaires